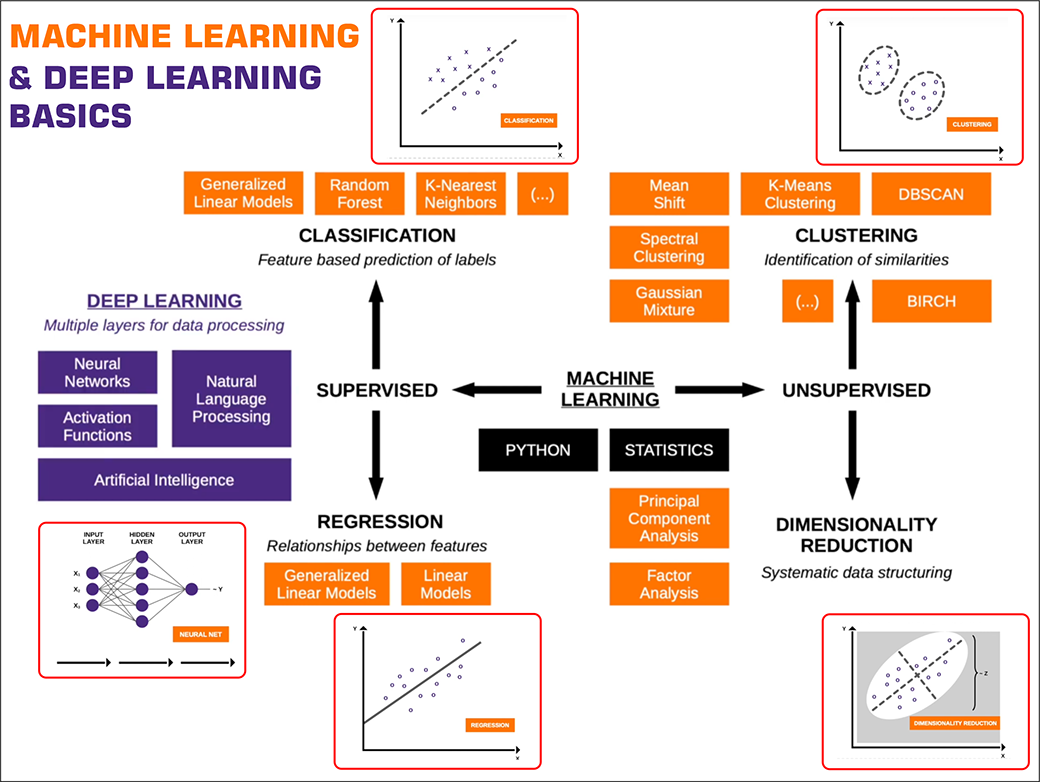

Feedforward Neural Network (FNN)

Ein Feedforward Neural Network ist die grundlegendste Architektur eines neuronalen Netzes. Informationen fließen in eine Richtung – von der Eingabeschicht über die versteckten Schichten zur Ausgabeschicht, ohne Rückkopplung.

Eigenschaften:

• Keine Schleifen oder Rückkopplungen.

• Gut geeignet für Aufgaben wie Klassifikation und Regression.

• Begrenzte Fähigkeit, zeitliche oder sequentielle Daten zu verarbeiten.

Beispiele:

• Bilderkennung

• Vorhersagen von Werten aus tabellarischen Daten

Convolutional Neural Network (CNN)

Ein Convolutional Neural Network ist speziell für die Verarbeitung von Daten mit räumlicher Struktur, wie Bildern, konzipiert. Es verwendet Faltungsoperationen (Convolutions), um lokale Merkmale wie Kanten oder Texturen zu erkennen.

Eigenschaften:

• Besteht aus Faltungsschichten, Pooling-Schichten und vollständig verbundenen Schichten.

• Reduziert die Anzahl der Parameter durch Gewichts-Sharing.

• Besonders effektiv bei Bildern, Videos und räumlichen Daten.

Beispiele:

• Gesichtserkennung

• Objekterkennung

• Medizinische Bildanalyse

Recurrent Neural Network (RNN)

Recurrent Neural Networks sind für die Verarbeitung von sequentiellen oder zeitabhängigen Daten geeignet. Sie haben eine Rückkopplungsschleife, die Informationen aus vorherigen Zuständen speichert und bei der Verarbeitung neuer Daten berücksichtigt.

Eigenschaften:

• Speicherung von vergangenem Kontext.

• Probleme wie der "Vanishing Gradient" können bei langen Sequenzen auftreten.

• Geeignet für Zeitreihen, Textdaten oder Audioverarbeitung.

Beispiele:

• Sprachmodellierung

• Textvorhersage

• Analyse von Finanzzeitreihen

Long Short-Term Memory (LSTM)

LSTMs sind eine spezielle Art von RNNs, die entwickelt wurden, um das Problem des "Vanishing Gradient" zu lösen. Sie verwenden sogenannte Gating-Mechanismen, um relevante Informationen über längere Zeiträume hinweg zu speichern und irrelevante Informationen zu vergessen.

Eigenschaften:

• Lange Speicherfähigkeit durch spezielle Speicherzellen.

• Effektiv bei der Verarbeitung von Langzeitabhängigkeiten.

• Häufig in NLP und Spracherkennung eingesetzt.

Beispiele:

• Maschinelle Übersetzung

• Spracherkennung

• Generierung von Musik oder Text

Generative Adversarial Network (GAN)

GANs bestehen aus zwei Netzwerken: einem Generator und einem Diskriminator, die gegeneinander trainiert werden. Der Generator erzeugt Daten, während der Diskriminator versucht, echte von gefälschten Daten zu unterscheiden.

Eigenschaften:

• Wettbewerbsbasierter Lernprozess.

• Der Generator wird trainiert, um immer realistischere Daten zu erzeugen.

• Erfordert sorgfältiges Training, da es zu Instabilitäten kommen kann.

Beispiele:

• Erzeugung von fotorealistischen Bildern

• Erstellung von Deepfakes

• Datenaugmentation

Autoencoder

Ein Autoencoder ist ein neuronales Netz, das darauf trainiert wird, Eingabedaten zu komprimieren (Kodierung) und anschließend wiederherzustellen (Dekodierung). Ziel ist es, die wichtigsten Merkmale der Daten zu lernen.

Eigenschaften:

• Besteht aus einem Encoder, der die Daten komprimiert, und einem Decoder, der die Daten rekonstruiert.

• Kann zur Dimensionsreduktion oder Merkmalsextraktion verwendet werden.

• Varianten wie den Variational Autoencoder (VAE) für probabilistische Modelle.

Beispiele:

• Rauschreduktion in Bildern

• Kompression von Daten

• Merkmalsextraktion

Transformer

Der Transformer ist eine revolutionäre Architektur, die auf dem Mechanismus der Aufmerksamkeit (Attention) basiert. Er wurde ursprünglich für die Verarbeitung von sequentiellen Daten entwickelt, ohne dass diese sequenziell verarbeitet werden müssen.

Eigenschaften:

• Verwendet Self-Attention, um den Kontext zwischen verschiedenen Teilen einer Sequenz zu verstehen.

• Skaliert gut mit großen Datenmengen.

• Grundlage moderner Modelle wie BERT, GPT und anderen.

Beispiele:

• Maschinelle Übersetzung

• Sprachverarbeitung (NLP)

• Textgenerierung

Zusammenfassung der Architekturen

• FNN: Basisarchitektur für einfache Aufgaben.

• CNN: Fokus auf Bild- und räumliche Daten.

• RNN: Für sequenzielle und zeitabhängige Daten.

• LSTM: Erweiterung von RNNs für Langzeitabhängigkeiten.

• GAN: Daten generieren durch konkurrierendes Training.

• Autoencoder: Datenkompression und Rekonstruktion.

• Transformer: Moderne NLP- und Sequenzverarbeitung mit Self-Attention.

Jede Architektur ist für spezifische Anwendungsfälle optimiert und bringt eigene Stärken und Herausforderungen mit sich.

Vorwärtspropagation (Forward Propagation)

Die Vorwärtspropagation beschreibt den Prozess, bei dem Eingabedaten durch das neuronale Netz fließen, um eine Ausgabe zu erzeugen. Dabei werden die Eingaben mit den Gewichten und Bias der Neuronen verrechnet und durch Aktivierungsfunktionen transformiert.

Ablauf:

1. Daten werden von der Eingabeschicht zu den versteckten Schichten weitergeleitet.

2. Jede Schicht berechnet Ausgaben und gibt sie an die nächste weiter.

3. Am Ende liefert die Ausgabeschicht ein Ergebnis (z. B. eine Vorhersage).

Backpropagation

Backpropagation ist der Kernalgorithmus, der verwendet wird, um die Gewichte und Bias im neuronalen Netz zu aktualisieren. Er basiert auf dem Gradientenabstieg und hilft, den Fehler des Modells zu minimieren.

Ablauf:

1. Der durch die Fehlerfunktion berechnete Fehler wird von der Ausgabeschicht zurück zu den vorherigen Schichten propagiert.

2. Der Gradientenfluss bestimmt, wie die Gewichte angepasst werden müssen, um den Fehler zu reduzieren.

Ziel: Das Modell so zu optimieren, dass die Vorhersagen genauer werden.

Fehlerfunktion (Loss Function)

Die Fehlerfunktion misst, wie gut oder schlecht das Modell performt. Sie quantifiziert den Unterschied zwischen den vorhergesagten und den tatsächlichen Werten.

Beispiele:

• Mean Squared Error (MSE): Für Regression.

• Cross-Entropy Loss: Für Klassifikationsprobleme.

Ziel: Die Fehlerfunktion während des Trainings zu minimieren.

Gradient Descent

Gradient Descent ist ein Optimierungsalgorithmus, der die Gewichte so anpasst, dass der Wert der Fehlerfunktion minimiert wird. Es basiert auf der Ableitung (Gradient), die anzeigt, in welche Richtung die Gewichte angepasst werden müssen.

Varianten:

• Batch Gradient Descent: Verwendet alle Daten auf einmal, kann aber langsam sein.

• Stochastic Gradient Descent (SGD): Verwendet einzelne Datenpunkte pro Schritt, was schneller ist, aber mehr Schwankungen verursacht.

Stochastic Gradient Descent (SGD)

SGD ist eine Variante des Gradientenabstiegs, bei der Gewichte nach jeder einzelnen Trainingsinstanz angepasst werden, anstatt den gesamten Datensatz zu verwenden.

Vorteile:

• Schneller für große Datensätze.

• Kann lokale Minima umgehen, da es zufällige Schwankungen einführt.

Nachteil: Kann zu instabilem Verhalten führen, wenn die Schwankungen zu groß sind.

Optimierungsalgorithmen (z. B. Adam, RMSprop)

Optimierungsalgorithmen verbessern den Gradientenabstieg, indem sie die Lernrate dynamisch anpassen oder zusätzliche Informationen nutzen.

• Adam (Adaptive Moment Estimation): Kombiniert die Vorteile von Momentum und RMSprop. Es passt die Lernrate basierend auf der Historie der Gradienten an.

• RMSprop: Reduziert Schwankungen des Gradientenabstiegs, indem es eine gleitende Mittelwertbildung des Gradienten verwendet.

• Momentum: Beschleunigt den Gradientenabstieg, indem vergangene Änderungen berücksichtigt werden.

Learning Rate

Die Lernrate gibt an, wie groß die Schritte sind, die das Modell bei der Gewichtsaktualisierung macht.

Herausforderungen:

• Eine zu hohe Lernrate führt zu instabilem Training.

• Eine zu niedrige Lernrate macht das Training sehr langsam.

Lösungen:

• Lernratenpläne (z. B. Reduzierung der Lernrate bei Stagnation).

• Adaptive Lernraten (z. B. durch Adam oder RMSprop).

Epoch

Eine Epoche beschreibt einen vollständigen Durchgang durch den gesamten Trainingsdatensatz. Nach jeder Epoche werden die Gewichte angepasst.

Beispiel: Wenn ein Datensatz 1.000 Beispiele enthält und in Batches zu 100 Beispielen aufgeteilt wird, besteht eine Epoche aus 10 Iterationen.

Batch Size

Die Batchgröße gibt an, wie viele Datenpunkte gleichzeitig verarbeitet werden, bevor die Gewichte aktualisiert werden.

Arten:

• Batch Gradient Descent: Verwendet den gesamten Datensatz als Batch.

• Mini-Batch Gradient Descent: Nutzt kleine Batches (z. B. 32 oder 64 Beispiele).

• Stochastic Gradient Descent: Verarbeitet ein Beispiel pro Iteration.

Auswirkungen:

• Kleinere Batches benötigen weniger Speicher, können aber mehr Schwankungen verursachen.

• Größere Batches sind stabiler, benötigen jedoch mehr Rechenleistung.

Overfitting

Overfitting tritt auf, wenn ein Modell die Trainingsdaten zu gut lernt, aber auf neuen Daten schlecht abschneidet. Es erkennt Muster, die für das Training spezifisch sind, statt generelle Muster zu lernen.

Anzeichen:

• Sehr niedriger Fehler auf den Trainingsdaten.

• Hoher Fehler auf den Validierungs- oder Testdaten.

Lösungen:

• Regularisierung.

• Verwendung eines Validierungsdatensatzes.

• Datenaugmentation.

Underfitting

Underfitting tritt auf, wenn ein Modell nicht in der Lage ist, die zugrunde liegenden Muster in den Daten zu lernen. Dies führt zu schlechter Leistung sowohl auf Trainings- als auch Testdaten.

Anzeichen:

• Hohe Fehler auf Trainings- und Testdaten.

• Modell ist zu einfach oder nicht ausreichend trainiert.

Lösungen:

• Erhöhung der Modellkomplexität.

• Mehr Trainingszeit oder größere Lernrate.

Regularisierung

Regularisierungstechniken verhindern Overfitting, indem sie das Modell daran hindern, sich zu sehr auf die Trainingsdaten zu spezialisieren.

Methoden:

• L1-Regularisierung (Lasso): Fügt eine Strafe basierend auf der absoluten Größe der Gewichte hinzu.

• L2-Regularisierung (Ridge): Fügt eine Strafe basierend auf der quadratischen Größe der Gewichte hinzu.

• Dropout: Deaktiviert zufällig Neuronen während des Trainings, um das Modell zu generalisieren.

• Datenaugmentation: Erhöht die Menge und Vielfalt der Trainingsdaten.

Zusammenhang der Begriffe

Der Trainingsprozess umfasst mehrere Schritte:

1. Daten fließen durch das Netzwerk (Vorwärtspropagation).

2. Der Fehler wird berechnet (Fehlerfunktion).

3. Der Fehler wird zurückpropagiert (Backpropagation).

4. Gewichte und Bias werden optimiert (Gradient Descent, Optimierungsalgorithmen).

5. Der Prozess wiederholt sich über mehrere Epochen, wobei die Größe der Datenbatches (Batch Size) variiert.

Um Über- oder Unteranpassung zu vermeiden, kommen Techniken wie Regularisierung, geeignete Lernraten und Architektur-Anpassungen zum Einsatz.

Mean Squared Error (MSE)

Die Mean Squared Error (MSE) ist eine der häufigsten Fehlerfunktionen, die in Regression verwendet wird. Sie misst den Durchschnitt der quadrierten Differenzen zwischen den vorhergesagten und den tatsächlichen Werten.

Eigenschaften:

• Bestraft größere Abweichungen stärker, da die Fehler quadriert werden.

• Empfindlich gegenüber Ausreißern, da diese das Ergebnis dominieren können.

• Liefert einen glatten Gradienten, der nützlich für die Optimierung ist.

Einsatzbereich:

• Regression, z. B. Vorhersage von Hauspreisen oder Aktienkursen.

Beispiel: Wenn ein Modell 50 vorhersagt, der tatsächliche Wert aber 60 ist, beträgt der Fehler 10, und MSE würde diesen Fehler quadrieren, sodass er 100 beträgt.

Cross-Entropy Loss

Die Cross-Entropy Loss wird häufig bei Klassifikationsproblemen verwendet, insbesondere wenn die Ausgabewerte Wahrscheinlichkeiten darstellen (z. B. mit der Softmax-Funktion). Sie misst die Divergenz zwischen den vorhergesagten Wahrscheinlichkeiten und den tatsächlichen Klassen.

Eigenschaften:

• Liefert hohe Werte, wenn die vorhergesagte Wahrscheinlichkeit für die korrekte Klasse gering ist.

• Bestraft falsche Klassifikationen stark.

• Sehr effektiv für mehrklassige Klassifikationsprobleme.

Einsatzbereich:

• Klassifikation mit zwei oder mehreren Klassen, z. B. Bildklassifikation oder Textklassifikation.

Beispiel: Wenn das Modell eine Katze mit 80 % Wahrscheinlichkeit und einen Hund mit 20 % Wahrscheinlichkeit vorhersagt, der tatsächliche Wert jedoch Hund ist, wird die Cross-Entropy Loss entsprechend hoch ausfallen.

Hinge Loss

Die Hinge Loss wird hauptsächlich bei binären Klassifikationsproblemen verwendet, insbesondere in Support Vector Machines (SVMs). Sie misst, wie stark die Klassifikation vom tatsächlichen Wert abweicht, indem sie eine Marge einführt, die die Trennung zwischen Klassen maximiert.

Eigenschaften:

• Bestraft falsch klassifizierte Punkte sowie korrekt klassifizierte Punkte, die zu nah an der Entscheidungsgrenze liegen.

• Setzt voraus, dass die Ausgabewerte auf +1 (positive Klasse) und −1 (negative Klasse) skaliert sind.

Einsatzbereich:

• Klassifikationsprobleme mit strengen Trennungen, wie SVMs oder lineare Klassifikatoren.

Beispiel: Wenn ein Punkt der positiven Klasse nahe der Grenze zwischen den Klassen liegt, wird die Hinge Loss erhöht, selbst wenn die Klassifikation korrekt ist.

Mean Absolute Error (MAE)

Die Mean Absolute Error (MAE) misst den Durchschnitt der absoluten Differenzen zwischen den vorhergesagten und tatsächlichen Werten. Anders als MSE bestraft MAE große Fehler nicht überproportional.

Eigenschaften:

• Robuster gegenüber Ausreißern, da die Fehler nicht quadriert werden.

• Liefert weniger glatte Gradienten, was die Optimierung erschweren kann.

Einsatzbereich:

• Regression, insbesondere bei Daten mit Ausreißern.

Beispiel: Wenn ein Modell 50 vorhersagt, der tatsächliche Wert aber 60 ist, beträgt der Fehler 10, und dieser Wert wird direkt in die MAE aufgenommen.

Vergleich der Fehlerfunktionen

Funktion Einsatzbereich Empfindlichkeit Hauptvorteil Nachteil

MSE Regression Empfindlich gegenüber Ausreißern Glatter Gradient für Optimierung Verstärkt Ausreißer

Cross-Entropy Klassifikation Bestraft falsche Klassifikationen stark Effektiv für probabilistische Modelle Benötigt Wahrscheinlichkeiten

Hinge Loss Binäre Klassifikation (SVM) Bestraft Punkte nahe der Grenze Optimiert Margen zwischen Klassen Benötigt skalierte Ausgaben

MAE Regression Robust gegenüber Ausreißern Einfach zu interpretieren Nicht glatt, schwierig für Optimierung

Zusammenfassung

Die Wahl der Fehlerfunktion hängt von der spezifischen Aufgabe ab:

• MSE und MAE eignen sich für Regression, wobei MAE robuster gegen Ausreißer ist.

• Cross-Entropy ist der Standard für Klassifikationen.

• Hinge Loss ist nützlich für Klassifikationsprobleme, die maximale Margen erfordern, z. B. bei SVMs.

Lernrate (Learning Rate)

Die Lernrate ist ein entscheidender Hyperparameter, der bestimmt, wie groß die Schritte sind, die das Modell bei der Anpassung seiner Gewichte während des Trainings macht.

Eigenschaften:

• Eine hohe Lernrate ermöglicht schnellere Fortschritte, kann aber zu instabilem Verhalten oder dem Überspringen optimaler Lösungen führen.

• Eine niedrige Lernrate sorgt für stabileres Training, kann das Modell aber langsam machen oder in lokalen Minima gefangen halten.

Techniken:

• Lernraten-Scheduler: Dynamische Anpassung der Lernrate während des Trainings (z. B. Reduktion nach bestimmten Epochen).

• Adaptive Algorithmen: Optimierungsalgorithmen wie Adam passen die Lernrate automatisch an.

Best Practices:

• Starte mit moderaten Werten (z. B. 0,001) und passe sie basierend auf der Modellleistung an.

Dropout

Dropout ist eine Regularisierungstechnik, die während des Trainings zufällig Neuronen deaktiviert (d. h., ihre Ausgaben auf Null setzt), um Überanpassung (Overfitting) zu verhindern.

Eigenschaften:

• Fördert die Generalisierung, da das Modell nicht zu stark von bestimmten Neuronen abhängig wird.

• Erhöht die Robustheit des Netzwerks, indem es gezwungen wird, Informationen redundanter zu verteilen.

Parameter:

• Dropout-Rate: Gibt den Anteil der Neuronen an, die in jeder Trainingsiteration deaktiviert werden (typischerweise 0,2–0,5).

Best Practices:

• Dropout sollte nur während des Trainings aktiviert sein, nicht während der Validierung oder Vorhersage.

• Höhere Dropout-Raten können bei sehr tiefen Netzwerken erforderlich sein.

Momentum

Momentum ist ein Zusatz zum Gradientenabstiegsalgorithmus, der frühere Gradienten berücksichtigt, um die Konvergenz zu beschleunigen und Schwankungen zu reduzieren.

Eigenschaften:

• Beschleunigt die Bewegung in gleichmäßigen Richtungen, indem es "Trägheit" hinzufügt.

• Hilft, aus lokalen Minima herauszukommen.

• Reduziert Oszillationen, insbesondere in stark kurvigen oder flachen Bereichen der Fehlerlandschaft.

Parameter:

• Momentum-Wert: Liegt typischerweise zwischen 0,5 und 0,9. Höhere Werte sorgen für stärkere Glättung.

Best Practices:

• Momentum wird häufig zusammen mit Gradient Descent oder Optimierungsalgorithmen wie SGD verwendet.

Gewichtinitialisierung (Weight Initialization)

Die Initialisierung der Gewichte eines neuronalen Netzwerks ist entscheidend für die Geschwindigkeit und Stabilität des Trainings.

Techniken:

1. Zufällige Initialisierung: Gewichte werden zufällig gewählt, oft aus einer Normal- oder Gleichverteilung.

2. Xavier-Initialisierung: Geeignet für Netze mit Sigmoid- oder Tanh-Aktivierungsfunktionen, um die Varianz der Eingaben über alle Schichten hinweg zu erhalten.

3. He-Initialisierung: Optimiert für Netze mit ReLU-Aktivierungen, indem sie größere Werte für die Varianz verwendet.

4. Zero-Initialisierung: Setzt alle Gewichte auf Null. Dies ist selten sinnvoll, da es zu Symmetrieproblemen führt.

Herausforderungen:

• Schlechte Initialisierung (z. B. zu große oder zu kleine Gewichte) kann zu Problemen wie Vanishing Gradients oder Exploding Gradients führen.

Best Practices:

• Wähle die Initialisierungsmethode basierend auf der verwendeten Aktivierungsfunktion.

• Nutze bewährte Standards wie He- oder Xavier-Initialisierung für tiefere Netze.

Zusammenhang der Hyperparameter

1. Lernrate: Kontrolliert, wie schnell das Modell lernt. Eine falsche Wahl kann die Konvergenz erschweren.

2. Dropout: Verhindert Überanpassung, indem es das Netzwerk dazu zwingt, robustere Merkmale zu lernen.

3. Momentum: Glättet den Optimierungsprozess und beschleunigt das Finden von Minima.

4. Gewichtinitialisierung: Legt den Grundstein für ein stabiles und effizientes Training.

Durch die richtige Wahl und Kombination dieser Hyperparameter kann die Leistung und Stabilität neuronaler Netze erheblich verbessert werden.

Bildverarbeitung

Neuronale Netze, insbesondere Convolutional Neural Networks (CNNs), haben die Bildverarbeitung revolutioniert. Sie werden eingesetzt, um visuelle Daten wie Bilder oder Videos zu analysieren und interpretieren.

Typische Anwendungen:

• Objekterkennung: Identifizierung von Objekten in Bildern oder Videos (z. B. in autonomen Fahrzeugen).

• Bilderkennung: Klassifikation von Bildern, wie z. B. das Erkennen von Tieren, Pflanzen oder Krankheiten.

• Bildsegmentierung: Unterteilung eines Bildes in verschiedene Regionen (z. B. medizinische Bildanalyse).

• Deepfake-Technologie: Generierung realistisch wirkender Bilder oder Videos.

Technologien:

• CNNs, GANs, Autoencoder.

Spracherkennung

Spracherkennungssysteme verwenden neuronale Netze, um gesprochene Sprache in Text umzuwandeln. Dies erfordert die Verarbeitung von Audiosignalen und die Erkennung von Mustern in zeitabhängigen Daten.

Typische Anwendungen:

• Virtuelle Assistenten: Wie Alexa, Siri oder Google Assistant.

• Sprachgesteuerte Geräte: Smart-Home-Geräte oder fahrerlose Autos.

• Transkription: Umwandlung von Sprache in geschriebenen Text, z. B. für Untertitel.

Technologien:

• Recurrent Neural Networks (RNNs), Long Short-Term Memory (LSTM), Transformer-basierte Modelle wie Wav2Vec.

Textverarbeitung (NLP)

Natural Language Processing (NLP) umfasst die Analyse und Generierung von natürlicher Sprache durch neuronale Netze. Transformer-basierte Architekturen wie BERT und GPT haben NLP-Anwendungen maßgeblich verbessert.

Typische Anwendungen:

• Maschinelle Übersetzung: Automatische Übersetzung von Text (z. B. Google Translate).

• Chatbots: Automatisierte Konversationen für Kundensupport oder Marketing.

• Sentiment-Analyse: Erkennung von Meinungen oder Stimmungen in Texten, z. B. in Social-Media-Daten.

• Textzusammenfassung: Automatisches Erstellen von Kurzfassungen langer Texte.

Technologien:

• Transformer-Modelle (z. B. GPT, BERT), RNNs, LSTMs.

Zeitreihenanalyse

Zeitreihenanalyse befasst sich mit Daten, die in chronologischer Reihenfolge erfasst wurden. Neuronale Netze helfen dabei, Muster und Abhängigkeiten in diesen Daten zu erkennen.

Typische Anwendungen:

• Vorhersagen: Z. B. Wetterprognosen, Aktienkursvorhersagen, Energieverbrauch.

• Anomalieerkennung: Identifizierung ungewöhnlicher Muster, z. B. in Maschinendaten oder Netzwerken.

• Finanzanalyse: Modellierung von Markttrends und Risikoanalyse.

Technologien:

• RNNs, LSTMs, Gated Recurrent Units (GRUs), Temporal Convolutional Networks (TCNs).

Robotik

In der Robotik werden neuronale Netze eingesetzt, um Maschinen mit menschenähnlichen Fähigkeiten auszustatten. Sie ermöglichen es Robotern, ihre Umgebung zu verstehen und darauf zu reagieren.

Typische Anwendungen:

• Autonomes Fahren: Wahrnehmung der Umgebung, Wegfindung und Entscheidungsfindung.

• Industrieroboter: Automatisierung von Fertigungsprozessen, wie z. B. Schweißen oder Montage.

• Serviceroboter: Roboter für Hausarbeit, Gesundheitswesen oder Rettungseinsätze.

• SLAM (Simultaneous Localization and Mapping): Erstellung von Karten und gleichzeitige Navigation.

Technologien:

• Reinforcement Learning, Deep Learning, Sensorfusion.

Empfehlungssysteme

Empfehlungssysteme nutzen neuronale Netze, um Benutzerpräferenzen zu analysieren und personalisierte Vorschläge zu machen. Sie spielen eine Schlüsselrolle in E-Commerce, Streaming-Plattformen und sozialen Netzwerken.

Typische Anwendungen:

• Produktempfehlungen: Vorschläge basierend auf bisherigen Käufen oder Suchanfragen (z. B. Amazon, eBay).

• Content-Empfehlungen: Personalisierte Inhalte auf Streaming-Plattformen wie Netflix oder Spotify.

• Soziale Netzwerke: Vorschläge für Freunde, Gruppen oder Beiträge (z. B. Facebook, LinkedIn).

Technologien:

• Collaborative Filtering, Matrixfaktorisierung, Deep Learning, Hybridansätze.

Zusammenhang und Bedeutung

Neuronale Netze sind ein wesentlicher Bestandteil moderner Technologien, die unser tägliches Leben beeinflussen. Ob in der Bildverarbeitung, bei Sprachassistenten oder in der personalisierten Unterhaltung – ihre Fähigkeit, komplexe Muster zu erkennen, macht sie zu einem unverzichtbaren Werkzeug in einer Vielzahl von Branchen. Die Wahl der spezifischen Technologie hängt vom jeweiligen Anwendungsfall ab.

Early Stopping

Early Stopping ist eine Technik, bei der das Training eines neuronalen Netzes vorzeitig beendet wird, sobald die Leistung auf einem Validierungsdatensatz nicht mehr verbessert wird. Dies verhindert Überanpassung (Overfitting), bei dem das Modell die Trainingsdaten zu gut lernt, aber auf neuen Daten schlecht generalisiert.

Wie es funktioniert:

1. Während des Trainings wird die Leistung des Modells regelmäßig auf einem separaten Validierungsdatensatz überprüft.

2. Wenn die Validierungsleistung über mehrere Epochen stagniert oder sich verschlechtert, wird das Training gestoppt.

3. Die Gewichte des Modells werden auf den besten Zustand zurückgesetzt.

Vorteile:

• Reduziert das Risiko von Overfitting.

• Spart Rechenressourcen, da das Training nicht unnötig lange dauert.

Einsatzbereiche:

• Besonders nützlich, wenn das Risiko von Overfitting hoch ist oder die Anzahl der verfügbaren Daten begrenzt ist.

Batch Normalization

Batch Normalization ist eine Technik, die dazu beiträgt, den Trainingsprozess zu stabilisieren und zu beschleunigen. Sie normalisiert die Eingaben jeder Schicht, sodass sie einen stabilen Mittelwert und eine feste Standardabweichung haben.

Wie es funktioniert:

1. Während des Trainings werden die Eingaben jeder Schicht in jedem Mini-Batch normalisiert (d. h., sie werden skaliert und verschoben).

2. Zwei lernbare Parameter (Skalierung und Verschiebung) werden eingeführt, damit das Netzwerk die optimale Verteilung lernen kann.

Vorteile:

• Beschleunigt das Training, da die Gradienten stabiler sind.

• Reduziert die Abhängigkeit von der Initialisierung der Gewichte.

• Kann als leichte Form der Regularisierung wirken und Overfitting reduzieren.

Einsatzbereiche:

• Häufig in tiefen Netzwerken wie CNNs und RNNs verwendet.

Data Augmentation

Data Augmentation ist eine Technik, um die Menge und Vielfalt der Trainingsdaten künstlich zu erhöhen. Dies wird erreicht, indem die vorhandenen Daten transformiert oder modifiziert werden, ohne dass die zugrunde liegende Bedeutung verloren geht.

Wie es funktioniert:

• Für Bilder: Transformationen wie Drehungen, Spiegelungen, Skalierungen, Zufallsbeschnitte oder Farbveränderungen.

• Für Text: Ersetzung von Wörtern durch Synonyme, Hinzufügen von Tippfehlern oder Umordnung von Satzteilen.

• Für Zeitreihen: Hinzufügen von Rauschen, Verschiebung oder Verzerrung der Daten.

Vorteile:

• Reduziert Overfitting, da das Modell robust gegenüber Variationen wird.

• Erhöht die Generalisierungsfähigkeit, insbesondere bei begrenzten Datensätzen.

Einsatzbereiche:

• Besonders nützlich in der Bildverarbeitung, Sprachverarbeitung und bei kleinen Datensätzen.

Transfer Learning

Transfer Learning ist eine Technik, bei der ein Modell, das auf einer ähnlichen Aufgabe trainiert wurde, als Ausgangspunkt für eine neue, verwandte Aufgabe verwendet wird. Statt von Grund auf neu zu trainieren, wird ein bereits trainiertes Modell "feinabgestimmt" (fine-tuned).

Wie es funktioniert:

1. Ein vortrainiertes Modell (z. B. ResNet, BERT) wird geladen.

2. Die unteren Schichten (die allgemeine Merkmale gelernt haben) bleiben oft unverändert.

3. Die oberen Schichten (die spezialisierte Merkmale lernen) werden für die neue Aufgabe angepasst.

Vorteile:

• Spart Zeit und Rechenressourcen, da weniger Trainingsdaten benötigt werden.

• Führt oft zu besseren Ergebnissen, besonders wenn die verfügbaren Daten begrenzt sind.

• Ermöglicht die Nutzung von großen Modellen, die auf riesigen Datensätzen trainiert wurden.

Einsatzbereiche:

• Bildverarbeitung (z. B. mit vortrainierten CNNs wie VGG oder ResNet).

• NLP (z. B. mit vortrainierten Modellen wie BERT oder GPT).

• Andere Bereiche, in denen ähnliche Daten oder Aufgaben verwendet werden.

Zusammenfassung der Optimierungen

Technik Zweck Vorteile Einsatzbereiche

Early Stopping Beendet das Training vorzeitig Verhindert Overfitting, spart Rechenressourcen Modelle mit hohem Risiko für Overfitting

Batch Normalization Stabilisiert und beschleunigt Training Bessere Gradienten, weniger Abhängigkeit von Initialisierung Tiefe Netzwerke (CNNs, RNNs)

Data Augmentation Erhöht die Vielfalt der Daten Bessere Generalisierung, weniger Overfitting Bildverarbeitung, NLP, kleine Datensätze

Transfer Learning Nutzen vortrainierter Modelle Spart Zeit, verbessert Leistung bei kleinen Daten Bildverarbeitung, NLP, verwandte Aufgaben

Durch die Kombination dieser Techniken kann das Training von neuronalen Netzen effektiver, effizienter und robuster gestaltet werden.

TensorFlow

TensorFlow ist ein Open-Source-Framework von Google für maschinelles Lernen und Deep Learning. Es bietet eine flexible Plattform, um neuronale Netze zu erstellen, zu trainieren und bereitzustellen.

Eigenschaften:

• Unterstützt eine Vielzahl von Geräten, darunter CPUs, GPUs und TPUs.

• Ermöglicht die Entwicklung von Modellen sowohl auf niedriger Ebene (mit TensorFlow-Kern) als auch auf höherer Ebene (z. B. mit Keras).

• Eignet sich gut für die Produktion und Skalierung.

Typische Anwendungen:

• Bildverarbeitung, NLP, Zeitreihenanalyse, Reinforcement Learning.

• Einsatz in der Produktion, z. B. durch TensorFlow Serving für Modellbereitstellung.

Vorteile:

• Starke Community und umfangreiche Dokumentation.

• Breite Unterstützung für Hardware-Beschleunigung.

PyTorch

PyTorch ist ein Open-Source-Framework von Meta (ehemals Facebook), das besonders für Forschung und Entwicklung von Deep-Learning-Modellen beliebt ist. Es bietet eine dynamische Berechnungsgrafik, die intuitive Modellentwicklung ermöglicht.

Eigenschaften:

• Dynamische Berechnungsgrafik: Modelle können während der Laufzeit verändert werden.

• Einfache und pythonische Syntax, die sich anfühlt wie NumPy.

• Starke Unterstützung für GPU-Beschleunigung.

Typische Anwendungen:

• Forschungsprojekte, bei denen Flexibilität erforderlich ist.

• Entwicklung von Modellen in Bereichen wie NLP, Computer Vision und Reinforcement Learning.

Vorteile:

• Leicht verständlich und intuitiv.

• Breite Unterstützung durch Bibliotheken wie Hugging Face Transformers.

Keras

Keras ist eine High-Level-API für maschinelles Lernen, die ursprünglich unabhängig entwickelt wurde und jetzt offiziell in TensorFlow integriert ist. Es ermöglicht die schnelle und einfache Erstellung von neuronalen Netzen.

Eigenschaften:

• Einfacher und lesbarer Code.

• Unterstützung für verschiedene Backend-Engines wie TensorFlow, Theano und CNTK.

• Optimiert für schnelles Prototyping.

Typische Anwendungen:

• Einsteigerfreundliche Entwicklung von Deep-Learning-Modellen.

• Schnelles Prototyping und kleinere Projekte.

Vorteile:

• Benutzerfreundlich und gut dokumentiert.

• Eng integriert in TensorFlow für Skalierbarkeit.

Scikit-learn

Scikit-learn ist eine Bibliothek für maschinelles Lernen in Python, die auf NumPy, SciPy und Matplotlib basiert. Sie bietet Werkzeuge für Standard-ML-Methoden, ohne auf Deep Learning spezialisiert zu sein.

Eigenschaften:

• Unterstützt Algorithmen wie Klassifikation, Regression, Clustering und Dimensionsreduktion.

• Eignet sich hervorragend für kleinere bis mittelgroße Datenmengen.

Typische Anwendungen:

• Klassische maschinelle Lernaufgaben wie Entscheidungsbäume, Support Vector Machines und Random Forests.

• Datenvorverarbeitung und Evaluierung von Modellen.

Vorteile:

• Einfach zu bedienen und gut für den Einstieg geeignet.

• Umfangreiche Unterstützung für klassische ML-Algorithmen.

Theano

Theano ist eine frühe Open-Source-Bibliothek für Deep Learning, die von der Universität Montreal entwickelt wurde. Sie bietet effiziente Berechnungen für numerische Ausdrücke und ist besonders für GPU-Beschleunigung optimiert.

Eigenschaften:

• Automatische Differenzierung und GPU-Unterstützung.

• Grundlage für viele spätere Frameworks wie Keras.

Typische Anwendungen:

• Wissenschaftliche Projekte und Prototypen (in der Vergangenheit).

• Wird heute weniger häufig verwendet, da es durch modernere Frameworks wie TensorFlow und PyTorch ersetzt wurde.

Vorteile:

• Pionierarbeit im Bereich GPU-Beschleunigung und automatische Differenzierung.

• Gut für leichtere oder ältere Projekte geeignet.

Caffe

Caffe ist ein Deep-Learning-Framework, das sich auf Geschwindigkeit und Modularität konzentriert. Es wurde ursprünglich von der Berkeley Vision and Learning Center (BVLC) entwickelt und war besonders in der Bildverarbeitung populär.

Eigenschaften:

• Schnelle Verarbeitung, optimiert für Convolutional Neural Networks (CNNs).

• Unterstützt Modelle, die ohne umfangreiche Programmierung definiert werden können.

Typische Anwendungen:

• Bildverarbeitung, Objekterkennung und Segmentierung.

• Forschungsprojekte im Bereich Computer Vision.

Vorteile:

• Sehr effizient und schnell, insbesondere für Bildverarbeitung.

• Einfache Konfiguration durch Modelldefinitionsdateien.

ONNX (Open Neural Network Exchange)

ONNX ist ein Open-Source-Format für die Interoperabilität von KI-Modellen. Es ermöglicht den Austausch von Modellen zwischen verschiedenen Frameworks wie TensorFlow, PyTorch und Caffe.

Eigenschaften:

• Standardisiert den Austausch von neuronalen Netzen zwischen verschiedenen Frameworks.

• Unterstützt Export und Deployment auf verschiedenen Plattformen.

Typische Anwendungen:

• Konvertierung von Modellen zwischen Frameworks.

• Bereitstellung von Modellen in produktionsreifer Umgebung.

Vorteile:

• Fördert die Interoperabilität zwischen verschiedenen Frameworks.

• Unterstützt eine breite Palette von Hardware und Software.

Zusammenfassung der Werkzeuge und Frameworks

Tool Zweck Stärken Typische Anwendungen

TensorFlow Deep Learning und Produktion Skalierbarkeit, Hardware-Unterstützung Bildverarbeitung, NLP, Reinforcement Learning

PyTorch Forschung und Entwicklung Dynamische Berechnungsgrafik, Flexibilität Forschung, NLP, Computer Vision

Keras High-Level-API für Deep Learning Einfachheit, schnelle Prototypenerstellung Einsteigerprojekte, TensorFlow-Integration

Scikit-learn Klassisches maschinelles Lernen Einfache Nutzung, klassische ML-Algorithmen Klassifikation, Clustering, Vorverarbeitung

Theano Numerische Berechnungen, GPU-Beschleunigung Pionierarbeit, historisch wichtig Selten genutzte ältere Projekte

Caffe Schnelle Bildverarbeitung Effizienz, Bildspezialisierung Bildklassifikation, Forschungsprojekte

ONNX Interoperabilität von Modellen Austausch zwischen Frameworks, Deployment Konvertierung und Bereitstellung

Die Wahl des Tools hängt von der spezifischen Aufgabe, dem Erfahrungsniveau und den Anforderungen (z. B. Forschung, Prototyping oder Produktion) ab.

Feature Engineering

Feature Engineering bezeichnet den Prozess, aussagekräftige Merkmale (Features) aus Rohdaten zu erstellen, die maschinelle Lernmodelle besser verstehen und nutzen können. Ziel ist es, die Modellleistung zu verbessern, indem wichtige Informationen hervorgehoben und irrelevante Daten reduziert werden.

Wichtige Schritte:

• Merkmalsextraktion: Ableiten neuer Features aus bestehenden Daten (z. B. Berechnung von Durchschnittswerten, Zeitdifferenzen).

• Merkmalselektion: Auswahl der wichtigsten Features, um die Modellkomplexität zu reduzieren.

• Transformation: Umwandlung von Daten in ein besser interpretierbares Format (z. B. logarithmische Skalierung).

Beispiele:

• Berechnung der Dauer eines Ereignisses aus Start- und Endzeit.

• Erstellen von Dummy-Variablen (z. B. durch One-Hot-Encoding).

• Gruppierung von Daten nach Kategorien (z. B. Umsatz pro Produktkategorie).

One-Hot-Encoding

One-Hot-Encoding ist eine Technik, um kategoriale Variablen in numerische Daten umzuwandeln, die von maschinellen Lernmodellen verarbeitet werden können. Dabei wird jede Kategorie durch einen binären Vektor dargestellt.

Wie es funktioniert:

• Jede Kategorie einer Variable wird zu einer separaten Spalte.

• Für eine bestimmte Kategorie wird der Wert in ihrer Spalte auf „1“ gesetzt, während alle anderen Spalten „0“ enthalten.

Beispiel: Eine kategoriale Variable „Farbe“ mit den Werten {„Rot“, „Grün“, „Blau“} wird in folgendes Format umgewandelt:

Farbe Rot Grün Blau

Rot 1 0 0

Grün 0 1 0

Blau 0 0 1

Vorteile:

• Keine implizite Reihenfolge wie bei numerischen Kodierungen.

• Gut geeignet für ML-Modelle, die numerische Eingaben erfordern.

Nachteile:

• Kann bei vielen Kategorien zu einer hohen Dimensionalität führen (sogenanntes „Curse of Dimensionality“).

Normalisierung

Normalisierung ist der Prozess, numerische Daten auf einen einheitlichen Wertebereich zu bringen, typischerweise zwischen 0 und 1. Sie wird verwendet, um Unterschiede in der Größenordnung zwischen Features zu reduzieren.

Warum es wichtig ist:

• Viele Algorithmen (z. B. Gradient Descent, k-Nächste-Nachbarn) sind empfindlich gegenüber unterschiedlich skalierten Daten.

• Normalisierung sorgt dafür, dass alle Features gleich gewichtet in das Modell eingehen.

Methoden:

• Min-Max-Skalierung: Skaliert Werte linear auf einen Bereich zwischen 0 und 1.

• Z-Transformation (Standardisierung): Transformiert Daten so, dass sie einen Mittelwert von 0 und eine Standardabweichung von 1 haben.

Beispiel: Ein Feature mit Werten {50, 100, 200} wird durch Min-Max-Skalierung auf {0.0, 0.25, 1.0} skaliert.

Datenvorverarbeitung

Datenvorverarbeitung umfasst alle Schritte, die erforderlich sind, um Rohdaten in ein Format zu bringen, das für maschinelles Lernen geeignet ist. Sie ist ein entscheidender Schritt, da die Qualität der Daten direkten Einfluss auf die Modellleistung hat.

Wichtige Schritte:

1. Datenbereinigung:

- Umgang mit fehlenden Werten (z. B. Imputation, Entfernen von Zeilen).

- Behandlung von Ausreißern (z. B. Clipping oder Transformation).

- Entfernen von Duplikaten.

2. Umwandlung von Variablen:

- Konvertieren von kategorialen Variablen (z. B. One-Hot-Encoding).

- Transformation von Datumswerten in Zeitmerkmale (z. B. Jahr, Monat, Wochentag).

3. Skalierung und Normalisierung:

- Einheitliche Skala für numerische Features (z. B. Normalisierung, Standardisierung).

4. Datenaufteilung:

- Aufteilen des Datensatzes in Trainings-, Validierungs- und Testdaten.

Beispielprozess:

- Ein Datensatz mit fehlenden Werten wird bereinigt, kategoriale Variablen werden durch One-Hot-Encoding umgewandelt, und alle numerischen

Features werden normalisiert, bevor sie in ein neuronales Netz eingegeben werden.

Zusammenhang und Bedeutung

Prozess, Zweck, Typische Schritte.

Feature Engineering Verbesserung der Datenqualität durch Erstellung aussagekräftiger Merkmale. Merkmalsextraktion, Transformation, Selektion

One-Hot-Encoding. Umwandlung von kategorialen Daten in ein numerisches Format. Erstellen binärer Vektoren

Normalisierung Vereinheitlichung der Skala numerischer Daten. Min-Max-Skalierung, Standardisierung.

Datenvorverarbeitung. Vorbereitung der Daten für maschinelles Lernen Bereinigung, Umwandlung, Skalierung, Datenaufteilung.

Die Kombination dieser Techniken gewährleistet, dass die Daten für das Training optimal vorbereitet sind, was die Modellleistung und die Generalisierungsfähigkeit deutlich verbessert.

Verlustkurve (Loss Curve)

Die Verlustkurve zeigt den Verlauf der Fehlerfunktion (Loss) über die Trainings- und Validierungsphasen. Sie ist ein wichtiger Indikator für das Training eines Modells.

Eigenschaften:

• Trainingsverlust: Der Loss auf dem Trainingsdatensatz.

• Validierungsverlust: Der Loss auf dem Validierungsdatensatz, der verwendet wird, um die Generalisierungsfähigkeit des Modells zu überwachen.

Interpretation:

• Sinkender Trainings- und Validierungsverlust: Das Modell lernt und passt sich den Daten an.

• Abweichung zwischen Trainings- und Validierungsverlust: Kann ein Anzeichen für Overfitting sein (Trainingsverlust sinkt, Validierungsverlust steigt).

• Stagnation: Deutet darauf hin, dass das Modell sein Optimierungspotenzial erreicht hat.

Beispielanwendung:

• Überwachung während des Trainings, um den optimalen Punkt für Early Stopping zu finden.

Genauigkeitskurve (Accuracy Curve)

Die Genauigkeitskurve zeigt die Entwicklung der Genauigkeit (Accuracy) eines Modells während des Trainings. Sie gibt an, wie gut das Modell Vorhersagen trifft.

Eigenschaften:

• Trainingsgenauigkeit: Die Genauigkeit auf dem Trainingsdatensatz.

• Validierungsgenauigkeit: Die Genauigkeit auf dem Validierungsdatensatz.

Interpretation:

• Steigende Genauigkeit: Zeigt, dass das Modell lernt.

• Abweichung zwischen Trainings- und Validierungsgenauigkeit: Kann auf Overfitting hinweisen.

• Konstante oder sinkende Genauigkeit: Kann auf ein zu einfaches Modell (Underfitting) oder auf ein Problem im Trainingsprozess hindeuten.

Beispielanwendung:

• Evaluierung der Modellleistung während des Trainings.

Konfusionsmatrix

Die Konfusionsmatrix visualisiert die Leistung eines Klassifikationsmodells, indem sie die Vorhersagen mit den tatsächlichen Werten vergleicht. Sie zeigt die Anzahl der korrekt und falsch klassifizierten Beispiele.

Struktur:

• True Positives (TP): Richtig klassifizierte positive Beispiele.

• True Negatives (TN): Richtig klassifizierte negative Beispiele.

• False Positives (FP): Falsch klassifizierte positive Beispiele (falsch-positiver Fehler).

• False Negatives (FN): Falsch klassifizierte negative Beispiele (falsch-negativer Fehler).

Interpretation:

• Die Matrix bietet einen vollständigen Überblick über die Vorhersagequalität des Modells.

• Kann zur Berechnung von Kennzahlen wie Präzision, Recall, F1-Score und Genauigkeit verwendet werden.

Beispielanwendung:

• Analyse von Modellen für Aufgaben wie Krankheitsdiagnosen oder Betrugserkennung.

ROC-Kurve (Receiver Operating Characteristic Curve)

Die ROC-Kurve ist eine Visualisierung der Sensitivität (True Positive Rate) gegenüber der 1-Spezifität (False Positive Rate) eines Modells bei unterschiedlichen Schwellenwerten. Sie zeigt, wie gut ein Modell verschiedene Klassen trennen kann.

Eigenschaften:

• True Positive Rate (TPR): Anteil der korrekt klassifizierten positiven Fälle.

• False Positive Rate (FPR): Anteil der fälschlicherweise als positiv klassifizierten negativen Fälle.

Interpretation:

• Fläche unter der Kurve (AUC): Je näher der Wert bei 1 liegt, desto besser ist das Modell.

• Eine steilere Kurve deutet auf ein leistungsfähigeres Modell hin.

• Eine ROC-Kurve, die die Diagonale bildet, zeigt ein Modell mit Zufallsvorhersagen.

Beispielanwendung:

• Evaluierung von Modellen bei unbalancierten Datensätzen oder bei binären Klassifikationsaufgaben.

Zusammenfassung der Visualisierungen

Visualisierung Zweck Vorteile

Verlustkurve Überwachung des Trainingsprozesses Erkennt Overfitting und Optimierungspotenzial

Genauigkeitskurve Analyse der Vorhersagequalität Liefert direkten Einblick in die Klassifikationsleistung

Konfusionsmatrix Detaillierte Klassifikationsanalyse Identifiziert spezifische Fehler (z. B. FP und FN)

ROC-Kurve Bewertung der Trennfähigkeit des Modells Geeignet für Schwellenwert-basierte Klassifikationen und AUC-Berechnung

Einsatz im Workflow

1. Verlust- und Genauigkeitskurven helfen, den Fortschritt des Trainings zu überwachen und Probleme wie Overfitting oder Underfitting frühzeitig zu erkennen.

2. Konfusionsmatrix bietet eine detaillierte Analyse der Modellleistung auf Klassenebene.

3. ROC-Kurve ist ideal, um Modelle bei binären Klassifikationsaufgaben zu vergleichen, insbesondere bei unbalancierten Datensätzen.

Diese Visualisierungen bieten zusammen eine umfassende Grundlage zur Bewertung und Optimierung von Modellen.

Vanishing Gradient Problem

Das Vanishing Gradient Problem tritt auf, wenn Gradienten in neuronalen Netzen sehr klein werden, insbesondere bei tiefen Netzwerken. Dadurch werden die Gewichte in den unteren Schichten kaum aktualisiert, was das Lernen erschwert oder unmöglich macht.

Ursachen:

• Verwendung von Aktivierungsfunktionen wie Sigmoid oder Tanh, bei denen Gradienten bei großen oder kleinen Eingabewerten nahezu verschwinden.

• Tiefe Netzwerke verstärken diesen Effekt, da Gradienten über viele Schichten hinweg multipliziert werden.

Folgen:

• Langsames oder stagnierendes Training, besonders in frühen Schichten.

• Geringere Modellleistung aufgrund unzureichender Anpassung.

Lösungen:

• Verwendung von ReLU oder ähnlichen Aktivierungsfunktionen (z. B. Leaky ReLU, PReLU).

• Einsatz von Techniken wie Batch Normalization, die den Gradientenfluss stabilisieren.

• Netzarchitekturen wie LSTM oder GRU für sequentielle Daten.

Exploding Gradient Problem

Das Exploding Gradient Problem tritt auf, wenn Gradienten im Training exponentiell anwachsen, was zu numerischen Instabilitäten und unbrauchbaren Modellen führt.

Ursachen:

• Zu große Initialgewichte oder schlecht gewählte Hyperparameter.

• Tiefe Netzwerke mit stark verstärkten Gradienten.

Folgen:

• Unstabiler Trainingsprozess (z. B. Verlustwerte steigen unkontrolliert an).

• Schwierigkeiten, das Modell zu trainieren.

Lösungen:

• Gradient Clipping: Begrenzen der Gradienten auf einen maximalen Wert.

• Verwendung stabiler Initialisierungen, z. B. Xavier- oder He-Initialisierung.

• Einsatz von Optimierungsalgorithmen wie Adam oder RMSprop, die adaptive Lernraten verwenden.

Dead Neurons

Dead Neurons treten auf, wenn bestimmte Neuronen im Netzwerk dauerhaft inaktiv sind (Ausgabe bleibt konstant 0), was ihre Beteiligung am Lernprozess verhindert.

Ursachen:

• Verwendung der ReLU-Aktivierungsfunktion, bei der negative Eingaben 0 ergeben und keine Gradienten erzeugen.

• Schlechte Initialisierung der Gewichte oder zu große Lernraten.

Folgen:

• Verringerte Modellkapazität, da weniger Neuronen aktiv am Lernen beteiligt sind.

• Potenziell schlechtere Leistung des Modells.

Lösungen:

• Verwenden von ReLU-Varianten wie Leaky ReLU, PReLU oder Swish, die auch für negative Eingaben einen Gradienten erzeugen.

• Experimentieren mit kleineren Lernraten und besseren Gewichtinitialisierungen.

Datenbias

Datenbias tritt auf, wenn Trainingsdaten nicht repräsentativ für die Realität oder Zielpopulation sind. Dies führt dazu, dass das Modell verzerrte oder unfair diskriminierende Ergebnisse liefert.

Ursachen:

• Ungleichgewicht in der Datenerfassung (z. B. Unterrepräsentation bestimmter Gruppen).

• Historische Verzerrungen in den Daten.

Folgen:

• Diskriminierende Entscheidungen, z. B. bei Kreditwürdigkeitsbewertungen oder Einstellungsverfahren.

• Modelle, die in der realen Welt schlecht generalisieren.

Lösungen:

• Datenbereinigung: Entfernen oder Ausgleichen von Verzerrungen in den Daten.

• Fairness-Algorithmen: Methoden wie re-weighting oder bias mitigation.

• Bewusstsein: Überprüfung und Validierung des Modells auf faire Entscheidungen.

Interpretierbarkeit

Interpretierbarkeit bezieht sich darauf, wie gut ein Modell und seine Entscheidungen von Menschen verstanden werden können. Tiefe neuronale Netze sind oft schwer zu interpretieren, was ihre Akzeptanz in kritischen Anwendungen einschränkt.

Ursachen:

• Hohe Komplexität und nichtlineare Entscheidungsstrukturen.

• Viele Parameter und tief verschachtelte Berechnungen.

Folgen:

• Schwierigkeit, die Gründe für Entscheidungen zu erklären (z. B. bei medizinischen Diagnosen oder Finanzprognosen).

• Geringes Vertrauen der Nutzer in die Ergebnisse des Modells.

Lösungen:

• Feature Importance: Identifizierung wichtiger Merkmale, die die Vorhersage beeinflussen.

• Explainable AI (XAI): Werkzeuge wie LIME (Local Interpretable Model-agnostic Explanations) und SHAP (SHapley Additive exPlanations).

• Verwendung von transparenten Modellen (z. B. Entscheidungsbäume) für bestimmte Anwendungen, bei denen Interpretierbarkeit entscheidend ist.

Zusammenfassung der Probleme und Lösungen

Problem Ursachen Folgen Lösungen

Vanishing Gradient Kleine Gradienten in tiefen Schichten Langsames Training, geringe Modellleistung ReLU, Batch Normalization, LSTM

Exploding Gradient Große Gradienten, schlechte Initialisierung Instabilität, Trainingsabbrüche Gradient Clipping, Xavier-Initialisierung

Dead Neurons ReLU-Aktivierung, schlechte Initialisierung Verringerte Modellkapazität Leaky ReLU, bessere Lernraten

Datenbias Verzerrte oder unausgewogene Daten Diskriminierende oder unfaire Ergebnisse Datenbereinigung, Fairness-Algorithmen

Interpretierbarkeit Hohe Modellkomplexität Geringes Vertrauen, schwierige Fehleranalyse Explainable AI, Feature Importance, XAI-Tools

Diese Herausforderungen sind zentral für den Erfolg maschineller Lernmodelle und erfordern eine sorgfältige Planung und Optimierung.